-

Notifications

You must be signed in to change notification settings - Fork 2

New issue

Have a question about this project? Sign up for a free GitHub account to open an issue and contact its maintainers and the community.

By clicking “Sign up for GitHub”, you agree to our terms of service and privacy statement. We’ll occasionally send you account related emails.

Already on GitHub? Sign in to your account

4주차 과제 #5

Comments

|

과제 제출 예시 0조Fashion MNIST 학습 결과1. Feed forward network(3주차 과제 결과)

2. CNN + MaxPool

4. MobileNet(with pretrained weights)

5. MobileNet(without pretrained weights)

결과 분석

|

4조Fashion MNIST 학습 결과

결과 분석

|

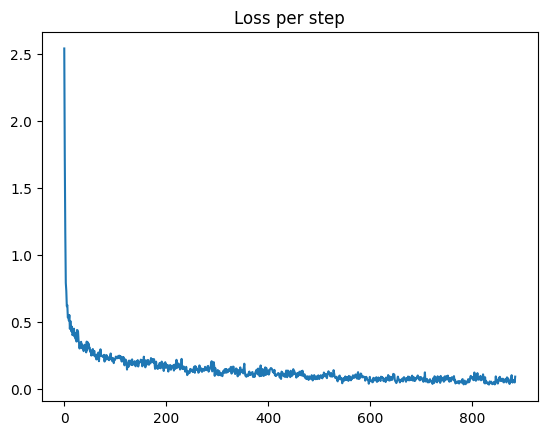

임세훈Fashion MNIST 학습 결과1. Feed Forward Network결과

2. CNN + MaxPool코드model = nn.Sequential(

nn.Conv2d(in_channels=1, out_channels=64, kernel_size=5, stride=1, padding="valid"),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2),

nn.Conv2d(in_channels=64, out_channels=256, kernel_size=5, stride=1, padding="valid"),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2),

nn.Flatten(),

nn.Linear(in_features=4*4*256, out_features=512),

nn.ReLU(),

nn.Linear(in_features=512, out_features=10)

)변경점

결과

3. MobileNet(with pretrained weights)코드from torchvision.models.mobilenet import mobilenet_v2

# weights 옵션을 통해 빈 모델만 불러오거나

# 사전학습된 파라미터를 불러오는 것 중 선택 가능

model = mobilenet_v2(weights=True)

# Fashion MNIST의 class 개수만큼 출력하도록 output layer 변형

model.classifier[1] = torch.nn.Linear(in_features=model.classifier[1].in_features, out_features=10)

_ = model.to(device)결과

4. MobileNet(without pretrained weights)코드from torchvision.models.mobilenet import mobilenet_v2

# weights 옵션을 통해 빈 모델만 불러오거나

# 사전학습된 파라미터를 불러오는 것 중 선택 가능

model = mobilenet_v2(weights=False)

# Fashion MNIST의 class 개수만큼 출력하도록 output layer 변형

model.classifier[1] = torch.nn.Linear(in_features=model.classifier[1].in_features, out_features=10)

_ = model.to(device)결과

결과 분석

사용한 Colab Notebook 주소는 여기에서 확인할 수 있습니다. |

강민우Fashion MNIST 학습 결과

Train accuracy: 94.21%

out_channels와 in_channels를 살짝 바꾸었고 epoch도 30으로 늘렸습니다. Train accuracy: 94.44% 1번과 비교했을 때 Train accuracy는 비슷하지만 Test accuracy가 더 높아졌으므로 overfitting이 줄었다고 볼 수 있을 것 같습니다.

Train accuracy: 99.34%

Train accuracy: 98.12% 결과 분석 학습 결과 분류 성능이 가장 뛰어난 모델은 4번 모델이였습니다. 파라미터를 불러오는 것이 훨씬 더 높은 Test accuracy가 나타났습니다. |

네 번째 과제: 최신 모델과 Transfer Learning의 효과 분석

회합 자료 링크: #1 (comment)

Colab Python 노트북을 사용한 모델 학습 코드 구성하기

fashion_mnist_cnn.ipynb

Step 1. 예시 노트북을 실행해보며 CNN 모델로 Fashion MNIST 튜닝하기

Step 2. MobileNet의 Fashion MNIST 분류 문제 transfer learning 효과 분석

The text was updated successfully, but these errors were encountered: